CoFHE:软件和硬件共同设计FHE-based机器学习作为服务

- 1智能系统工程系,印第安纳大学布卢明顿,美国

- 2学校网络科技、山东大学,济南,中国

作品简介:隐私问题时出现敏感数据作为服务外包是不可信的机器学习(MLaaS)平台。完全同态加密(FHE)出现的一个最有前途的解决方案来实现保护隐私MLaaS。但之前FHE-based MLaaS从软件和硬件两方面面临挑战。首先,FHE可以实现各种方案包括BGV、德国情报机构,CKKS,擅长不同FHE操作,如增加、乘法和旋转。不同的神经网络结构需要不同数量的FHE操作,从而倾向于不同FHE方案。然而,最先进的MLaaS只是天真地选择一个FHE计划建造FHE-based神经网络不考虑其他FHE方案。其次,先进的MLaaS使用耗电硬件加速器FHE-based推论过程。通常,之前高性能FHE加速器消费

方法:在本文中,我们提出一个软件和硬件协同设计FHE-based MLaaS框架,CoFHE。从软件的角度来看,我们建议一个FHE编译器来选择最佳FHE网络架构方案。我们也建立一个低功耗和高密度NAND-SPIN和SRAM混合FHE暂时存储器系统硬件加速器。

结果:平均而言,在相同的安全性和准确性的限制,平均CoFHE加速各种FHE-based推断18%,并减少各种FHE-based推论的能源消耗26%。

讨论:CoFHE大大提高了延迟和能源效率的FHE-based MLaaS。

1介绍

机器学习作为服务(MLaaS)里贝罗et al。(2015)是最重要的一个解决方案来解决各种各样的问题,从计算机视觉推荐系统。普通用户感觉不愿意上传他们的敏感数据,例如,健康或财务记录,不可信云中的服务器。新的立法欧盟通用数据保护监管Hoofnagle et al。(2019)和加州消费者隐私的行为Camhi和里昂(2018)需要更细心MLaaS提供者收集、存储、利用、传递用户的平均数据。为了保护用户的隐私,完全同态加密(FHE)的保护隐私的神经网络Gilad-Bachrach et al。(2016);Brutzkus et al。(2019);Dathathri et al . (2019,Dathathri et al。(2020);卢和江(2021)提出了对加密数据进行神经直接推论。大多数先进的FHE方案包括德国情报机构风扇和·维(2012),BGVHalevi和Shoup博士(2015)和CKKS荣格et al。(2020)只支持FHE乘法和添加。尽管FHE-based神经网络近似其活化层2阶多项式,他们仍然可以获得竞争力的推理精度Gilad-Bachrach et al。(2016);Brutzkus et al。(2019);Dathathri et al。(2019),Dathathri et al。(2020);卢和江(2021)。然而,一个FHE-based神经网络推理是耗时的。一个典型的FHE-based神经网络的推理Dathathri et al。(2019),Dathathri et al。(2020)成本

尽管FHE可以由多个实现方案,即。,德国情报机构风扇和·维(2012),BGVHalevi和Shoup博士(2015)和CKKS荣格et al。(2020)之前,FHE-based神经网络Gilad-Bachrach et al。(2016);Brutzkus et al。(2019);Dathathri et al。(2019),Dathathri et al。(2020);卢和江(2021)只是天真地选择一个FHE方案没有考虑其他选择。不同的FHE方案有不同的优势江、(2022)。德国情报机构和BGV支持FHE整数乘法和加法,而CKKS擅长近似复杂的定点算法。此外,在相同的安全级别,不同FHE方案独特的SIMD批量大小,以及不同延迟执行添加时,乘法和旋转江、(2022)。不同的神经网络有不同的体系结构,即。,layer numbers, kernel sizes, and input/output channel numbers, may favor distinctive FHE schemes, because their FHE inferences have various bottlenecks, e.g., small batch size, slow multiplications, or slow rotations. Unfortunately, there is a total lack of a software tool that can select a suitable FHE scheme for a network architecture.

FHE硬件,尽管多个FHE硬件加速器岗et al。(2022);金et al。(2022);岗et al。(2021)提出高度优化的数论变换(NTT)单位过程在FHE多项式乘法操作,他们使用了许多耗电SRAM阵列连接由一个大型Network-on-Chip (NoC)形成一个256 MB

在本文中,我们提出一个软件和硬件协同设计FHE-based MLaaS框架,CoFHE前,应对软件和硬件的缺陷FHE-based神经网络。我们的贡献可以概括如下。

•在软件层面,我们提出一个CoFHE FHE编译器选择最佳FHE网络架构方案。我们的编译器简单背后的想法。,for a network architecture under a security level, our compiler generates BFV-, BGV-, and CKKS-based solutions, and then compares their client setup latencies, server inference latencies, and inference accuracies. At last, our compiler selects the best FHE scheme according to the design requirement.

•在硬件层面,我们建立一个低功耗和高密度NAND-Spintronic (SPIN)和混合暂时存储器SRAM FHE加速器。NAND-SPIN数组是高度密集的但它写延迟很长。便条簿内存使用NAND-SPIN数组来存储各种评价钥匙,因为它们是只读数据。暂时存储器采用NAND-SPIN和SRAM混合数组保持暗文,这可能会收到大量写流量。我们混合便条簿FHE加速器的内存大大降低了能源消耗大大降低FHE-based网络性能。

•实施、评估和对先进的硬件加速MLaaS CoFHE相比。平均而言,在相同的安全性和准确性的限制,CoFHE改善各种FHE-based神经网络的推理延迟18%,并减少各种FHE-based推论的能源消耗26%。

2背景

2.1完全同态加密

基础知识。完全同态加密(FHE)风扇和·维(2012)允许操作没有秘密密钥加密数据(暗文)。我们使用酒吧表示一个公钥,证交会表明分泌的关键,ϵ代表一个加密函数,和σ象征一个解密函数。同态操作可以定义⋄⋆,这样如果有另一个操作σ(ϵ(x1,酒吧)⋄ϵ(x2,酒吧),sec) =σ(ϵ(x1⋆x2,酒吧),sec),x1和x2是两个明文。最先进的FHE最初计划引入一个错误密文来保证安全。此外,每个同态操作引入了一定量的噪声到密文。当积累的噪音密文噪音超过了预算,一个错误发生在解密。FHE计划用一组固定的参数有一个噪声预算有限,因此只支持有限数量的同态操作。这就是所谓的夷为平地FHE。FHE方案可能定期使用引导操作Brakerski et al。(2014)减少噪音的密文,这样它可以支持无限数量的同态操作。这就是所谓的完全FHE。

符号。在这篇文章中,整数和实数都写在正常情况下,例如,问。多项式和向量都写在大胆的,例如,一个。多项式的向量和矩阵都写在大写粗体,例如,一个。我们使用一个下标表示索引,例如,一个我是i多项式或行一个。我们假设n是2的幂,整数和定义一个多项式环

FHE操作。我们使用FHE计划德国情报机构作为一个例子来解释最重要FHE操作如下。

•设置(λ)。对于一个安全参数λ,我们设置一个环的大小n,一个密文模量问,一个特殊的模量pcoprime来问,一个关键的分布χ和一个误差分布ΩR。

•加密。德国情报机构密文是加密作为一个向量的两个多项式

•解密。的解密计算

•加法。两个暗文c0= (c0,0,c1,0),c1= (c0 1,c1,- 1),一个FHE除了简单地添加了多项式的两个暗文和输出结果密文c= (c0,0+c0 1,c1,0+c1,- 1)。

•乘法。在一次FHE乘法,两个暗文c0= (c0,0,c1,0),c1= (c0 1,c1,- 1)第一次增加和组装来计算cx= (米0,米1,米2)= (c0,0c0 1,c0,0c1,- 1+c1,0c0 1,c1,0c1,- 1)。然后,key-switching (relinearization)操作发生米0产生两个多项式(u0,u1)=按键开关(米0)通过一个relinearization键。最终的输出是c= (米1+u0,米2+u1)。

•旋转。FHE SIMD-style配料方案支持风扇和·维(2012),可以包米明文(p0、…p米−1成密文。两个暗文之间的同态乘法或加法发生(c0,0,c1,0)和(c0 1,c1,- 1)等价于米之间的乘法或加法(p0,0、…p米−1,0]和[p0 1、…p米−1]。例如,一个FHE除了可以实现p0,0+p0 1、…p米−1,0+p米−1。一个FHE旋转操作旋转由几个明文密文插槽。例如,[p0,0、…p米−1,0)可以旋转(pn,0、…p米−1,0,p0,0、…pn−1,0),n明文插槽。FHE旋转也实现了通过一个旋转的关键。

relinearization和旋转键可以被称为评价键。评价键的大小与扩大密文模量大大增加问。

FHE方案。FHE可以通过各种实现方案包括德国情报机构风扇和·维(2012),BGVHalevi和Shoup博士(2015),CKKS荣格et al。(2020),FHEWDucas和Micciancio (2015),TFHEChillotti et al。(2018)。简要对比这些FHE计划所示表1。的word-wise FHE计划,即。,BGV,德国情报机构,CKKS, are built upon the Ring Learning With Error (RLWE) paradigmBrakerski et al。(2014)。他们擅长计算矢量乘法和添加。他们支持SIMD配料,它允许一个向量的明文加密为一个单一的密文。BGV和德国情报机构只支持整数算术运算,而CKKS更有效,在处理复杂定点数字。BGV相比,德国情报机构使用不同版本的relinearization FHE乘法。CKKS只支持近似计算,每个CKKS操作稍微修改的值部分密文的一部分。的引导操作BGV,德国情报机构和CKKS非常耗时。例如,延迟BGV引导操作成本几百秒Halevi和Shoup博士(2015)。相反,FHEW和开发TFHE错误(LWE)的学习模式Chillotti et al。(2018)。他们擅长FHE二进制逻辑操作,例如,NAND闪存,XOR,或。他们引导操作快。例如,TFHE引导只需要13女士在一个CPU上。虽然之前的工作交易所et al。(2018);卢和江(2019)使用TFHE来实现一个FHE神经网络使用位宽度量化权重低,这些highly-quantized神经网络极大地降低推理精度。最近的工作卢et al。(2020)执行线性层由TFHE BGV和活化层,但BGV之间的切换操作和TFHE非常缓慢,例如,几十秒。在本文中,我们只关注BGV,德国情报机构,由这些FHE CKKS,神经网络实现方案。

2.2 FHE-based神经网络

数据流。的数据流FHE-based MLaaS所示图1。客户端通常使用一个CPU处理器。她产生各种密钥,加密数据,并将只有密文发送给云端。不受信任的服务器在云中进行FHE-based神经推理Brutzkus et al。(2019)在加密数据上FHE硬件加速器并将加密结果发送回客户端。为了支持SIMD-style FHE操作,一个编码步骤是客户要求的包装很多数据到一个密文。编码、解码、加密和解密都是由客户端,而服务器执行只有FHE计算没有解密加密的数据。

FHE神经网络。FHE-based神经网络Gilad-Bachrach et al。(2016);Brutzkus et al。(2019);Dathathri et al . (2019,2020);卢和江(2021)创建支持直接推论加密数据。之前FHE-based网络近似非线性激活层的2阶多项式,并计算其线性(即。、卷积和全)层FHE乘法和添加。主要业务在线性层同态点积,如图所示图2。全层,加密的输入向量x组成的n(例如,n= 4)元素,而加密输出向量y有米(例如,米= 1)元素。之前FHE-based网络保持重量只有服务器端,所以权重不加密。明文权重矩阵W有一个尺寸n×米。同态点积可以计算

(在哪里x]意味着加密x;(y是加密的y;⋅表明FHE SIMD乘法成批的明文和成批的密文;和腐烂是指FHE旋转。所以日志2nFHE旋转需要积累的因素y。

2.3 FHE硬件加速器

FHE操作耗时且power-inefficient当运行在传统的cpu和gpuRiazi et al。(2020)。多个ASIC-based FHE加速器岗et al。(2022);金et al。(2022);岗et al。(2021)提出了提高能源效率和FHE操作的延迟。这些FHE ASIC加速器高度优化NTT单位加速最计算密集型的内核,即。多项式乘法,FHE操作。然而,保持大评价(relinearization和旋转)键和大暗文片上,这些加速器采用较快耗电SRAM阵列连接由一个大型NoC 512 MB暂时存储器金et al。(2022)。支持FHE 10∼20层,组成的神经网络的规模评估键和暗文大大增加(例如,128 MB

2.4 NAND-like自旋电子记忆体

NAND-Like自旋电子(NAND-SPIN)的记忆王et al。(2018)是一种低功耗和高密度内存技术,具有良好的CMOS兼容,因此可以直接与CMOS集成逻辑。此外,写NAND-SPIN细胞的耐力

2.5的动力

之前的硬件加速FHE-based MLaaS受限于它的软件和硬件设计。在软件层面,之前FHE-based神经网络Gilad-Bachrach et al。(2016);Brutzkus et al。(2019);Dathathri et al。(2019),Dathathri et al。(2020);卢和江(2021)只是天真地采用一个FHE方案没有考虑其他选择。同样的安全级别,不同FHE方案操作在不同的数据类型,支持不同的SIMD批量大小,并使用不同的延迟在执行添加、乘法和旋转江、(2022)不同设置延迟,导致在客户端,推理延迟在服务器端,和一个网络架构的推理精度。设置在客户端包括加密、解密和公共/私人密钥生成/评估。作为图4所示,我们使用BGV、BGV CKKS实现4特性逻辑回归算法金et al。(2018)和一个SqueezeNetDathathri et al。(2020)在CIFAR10工作。详细的实验方法是第四节所示。低功耗敏感物联网设备客户端设置的计算开销。德国情报机构有最小的客户端设置延迟,而BGV期间是最慢的在客户端设置。FHE-based推论,在物流BGV达到最短的延迟,而德国情报机构获得SqueezeNet最短的延迟。相比之下,CKKS精度为最高。因此,普通用户需要的软件工具来选择最好的FHE方案(即满足他们的目标。、客户端/服务器延迟和准确性)在构建一个FHE-based神经网络。在硬件层面上,最先进的FHE硬件加速器使用一个巨大的(例如,512 MB)耗电SRAM暂时存储器来存储评价所使用的密钥FHE乘法和旋转。所有暂时存储器SRAM阵列的连接使用大型的NoC缓冲存储器暂时存储传输数据。SRAM暂时存储器及其NoC消散大量的力量,之前的能源效率和降低FHE加速器。 For example, on the latest 7 nm FHE accelerator金et al。(2022),512 MB内存存储器便条簿和SRAM缓冲区(划痕+ SRAM NoC)在其NoC消耗61 W,即。、总功率的38%,和235年占领毫米2,即,63% of the chip area, as shown in图5。

图5。之前的SRAM便条簿和NoC SRAM缓冲FHE加速器金et al。(2022)。

3 CoFHE

W提出一个软件和硬件协同设计FHE-based MLaaS框架,CoFHE,解决之前的软件和硬件缺陷FHE-based神经网络。在软件层面上,我们提出一个编译器来选择最好的网络体系结构,以满足FHE方案设计的目标,即。,最短的延迟在服务器或客户端,或精度最高。在硬件层面上,我们建立一个低功耗NAND-SPIN和FHE SRAM混合暂时存储器系统硬件加速器。

3.1 multi-FHE-scheme编译器FHE-based神经网络

我们首先概要文件和基准三FHE计划的主要操作,并使用分析数据建立一个延迟CoFHE编译器/能源库。然后,我们精心设计的细节CoFHE编译器。

FHE方案分析。确定最有效的FHE方案每种类型的FHE操作,我们OpenFHE运行巴达维et al。(2022)在我们的CPU和ASIC基线金et al。(2022)。我们假定客户机使用CPU的基线,而服务器使用我们FHE ASIC基线。我们把FHE操作分为两组:客户机和服务器。正如我们在2.2节中介绍的,客户端需要生成私人,公共,relinearization和旋转键使用FHE-based神经网络。此外,客户端也有敏感数据加密和解密。相反,服务器执行只FHE FHE-based神经推理的算术运算。FHE操作,我们只考虑增加两个暗文(

•客户端。设置的延迟比较FHE-based神经网络在客户端所示图6,“深度N”是指FHE参数支持N连续FHE乘法。允许一个更大的FHE深度FHE-based网络组成的层,从而成倍地增加了在客户端设置延迟。除了解密,BGV最长需要延迟当深度很大,虽然CKKS最长的解密延迟。当FHE深度很小,也就是说,

•服务器。延迟和吞吐量的比较FHE乘法和加法在服务器端所示图7。大FHE深度呈指数级增加FHE延迟操作服务器的加速器。适应大深度、BGV,德国情报机构和CKKS必须使用一个更大的密文模量问的延迟,大大延长FHE乘法和添加。的深度

CoFHE编译器。我们提出了一个CoFHE FHE编译器选择最佳FHE神经网络架构方案图8。编译器可以在服务器端执行。对于一个l层网络配置包括内核大小(K我),输入/输出通道数(我我/O我),和重量值W我,1≤我≤l,编译器尝试三个FHE计划,即。,德国情报机构,CKKS BGV。编译器使用最新的明文数据编码的布局Brutzkus et al。(2019)批处理输入服务器的例子和权重,然后采用不同FHE参数Boemer et al。(2019)批量加密明文找到最小FHE参数,可以支持网络。最小FHE参数集可以直接转化为一个FHE深度用于查找我们的延迟/能源库来计算延迟/神经网络的服务器/客户端。我们CoFHE编译器还支持组合评价指标定义为α0⋅clat+α1⋅板条+α2⋅曾+α3⋅生+α4⋅acc,在那里α0∼α4hyper-parameters;clat意味着客户端延迟;板条是服务器端延迟;曾意味着客户端能量;生显示服务器端能量;和acc表示的准确性。最后,编译器所有重量数字转换成整数或定点表示基于FHE方案的数据类型和明文模量,然后对一些网络时代产生的推理精度FHE方案。服务器可以选择最好的FHE方案FHE-based网络实现最短的延迟服务器/客户机、服务器/客户机上最小的能量,精度最高,或组合评价指标。

3.2低功耗FHE暂时存储器系统硬件加速器

暂时存储器体系结构。减少能源消耗之前FHE硬件加速器,我们建立一个NAND-SPIN和SRAM混合暂时存储器系统由NAND-SPIN和SRAM混合NoC连接图9。NAND-SPIN和SRAM混合暂时存储器系统,所有评价键,即。,relinearization和腐烂一个t我onkeys, are stored in only NAND-SPIN scratchpad array, since FHE operations need to only read them while the NAND-SPIN read latency is close to SRAM. On the contrary, all ciphertexts are stored in the NAND-SPIN and SRAM hybrid arrays shown in图9,那里是一个大型NAND-SPIN数组和一个小SRAM阵列。作为图9 b所示,NAND-SPIN数组包含多个NAND-SPIN赋由h树结构连接。每个NAND-SPIN赋是一个数组NAND-SPIN细胞连接的垂直word-lines和水平bit-lines,如图所示图9 c。每个MTJ NAND-SPIN细胞是由一个字线和选定行译码器。NAND-SPIN细胞在一个水平线分享一位线选中一列写的多路复用器,可以感觉到/读出放大器/写驱动程序。所有NAND-SPIN和SRAM混合数组和NAND-SPIN数组连接NAND-SPIN和SRAM混合NoC中所示图9 d。混合NoC由多个虚拟通道。一个虚拟通道使用多路复用器选择NAND-SPIN银行或银行SRAM。NAND-SPIN银行用于存储非关键大块传输数据,而银行SRAM存储紧急小区传输数据。

便笺式内存管理。我们的便签内存管理算法很简单。所有只读评价各种FHE键操作存储在大型NAND-SPIN数组,而大多数暗文和其他中间结果保存在小SRAM阵列。如果SRAM容量不够大,数据交换操作发生在NAND-SPIN和SRAM阵列之间移动数据。

4实验方法

在本节中,我们介绍我们的实验方法的细节。

FHE方案。我们评估各种word-wise FHE方案包括德国情报机构风扇和·维(2012),BGVHalevi和Shoup博士(2015),CKKS荣格et al。(2020)。德国情报机构和BGV支持FHE确切整数算术运算,而CKKS执行近似复杂和定点算术运算。尽管三FHE计划支持引导,引导操作缓慢,例如,

FHE图书馆。我们研究了最新FHE图书馆OpenFHE (.9.5)巴达维et al。(2022)。图书馆使用o3与英特尔icc编译器编译优化国旗。

硬件基线。我们的CPU基线是Intel Xeon黄金6138 p 128 GB DDR4主内存。它有20 2 GHz的x86处理器共享一个27.5 MB L3缓存。每个核心支持avx - 512指令。热设计的CPU基线是195 W。我们选择的最新7纳米BTS FHE硬件加速器金et al。(2022),因为我们的ASIC基线。BTS (PEs)由2 k处理元素,每一种都有一个NTT单位,基本转换单元,一个模块化的乘数,模块化的加法器,256 KB SRAM便条簿数组。所有便签数组是由大型NoC连接。BTS运行在1.2 GHz和有两个HBM2e DRAM内存控制器。BTS支持所有三个FHE计划,即。德国情报机构,BGV, CKKS。完整的配置可以从BTS (金正日et al ., 2022)。我们假定客户机使用CPU的基线,而服务器采用ASIC基线。

编译器的实现。我们建造CoFHE NGraph-HE2编译器Boemer et al。(2019)。我们使用OpenFHE FHE后端CoFHE编译器来编译一个FHE-based神经网络的序列FHE操作可以由CPU执行的基准。我们的硬件基本可以使用其操作调度器和映射器运行FHE的顺序操作。

NAND-SPIN便条簿建模。我们采用了NVSIM董et al . (2012)估计的力量,延迟和面积开销NAND-SPIN和SRAM混合暂时存储器系统。我们设定的比率SRAM和NAND-SPIN混合内存1:8。

分析和仿真。我们使用了英特尔VTune工具配置文件所有FHE操作在我们的CPU基线。我们与CoFHE建模BTS NAND-SPIN和SRAM混合暂时存储器系统cycle-accurate FHE加速器模拟器,Sapphire-SimBanerjee et al。(2019)根据几个crypto-processor芯片进行验证。Sapphire-Sim的输入是我们CoFHE FHE操作时间表由编译器基于神经网络的体系结构。根据配置的加速器,Sapphire-Sim模拟周期级别执行,并为每个FHE数据移动操作,然后产生的总延迟和FHE-based神经网络的能源消耗。

网络体系结构。我们评估各种FHE-based神经网络架构。对于小规模的网络,我们认为是4特性逻辑回归算法金et al。(2018)(日志)乳腺病变的数据集迈凯轮et al。(2009)。对于中等规模的网络,我们选择了一个4层CNN(罗拉)Brutzkus et al。(2019)推断MNIST数据集。对大规模网络,我们选择了cnn包括SqueezeNet(汉堡)Dathathri et al。(2020)和AlexNet(亚历克斯)Dathathri et al。(2020)致力于CIFAR10数据集。

计划。我们实现和比较以下方案。

BTS•。ASIC硬件加速器金et al。(2022)与一个512 MB SRAM便条簿存储系统运行所有FHE-based神经的推论。

•CKKSBTS。该方案实现了神经网络通过CKKS使用最先进的编译器Dathathri et al。(2020)BTS,运行在512 MB内存存储器便条簿。

•CoFHE。方案实现了神经网络使用我们CoFHE编译器和运行它们BTS NAND-SPIN和SRAM混合暂时存储器系统的同一地区开销512 MB内存存储器便条簿。

5评估和结果

5.1 CoFHE com堆垛机

延迟、能源和准确性比较FHE-based CoFHE编译器生成的神经网络与不同FHE方案包括BGV,德国情报机构,CKKS所示图10。所有结果规范化BGV延迟和能量。

图10。延迟、能源和产生的各种FHE-based网络精度比较我们CoFHE编译器(一):客户端设置延迟;(B):客户端设置能源;(C):服务器推理延迟;(D):服务器推断能量;(E):推理精度;所有结果规范化BGV延迟和能量。

首先,所有FHE设置操作包括加密、解密和各种键生成执行CPU基线。作为图10所示,设置BGV-based神经网络的延迟是最长的,由于其缓慢relinearization和旋转键生成。和BFV-based神经网络比CKKS-based神经网络设置延迟时间短,自CKKS解密操作中最慢三FHE方案。客户端设置的能源消耗三FHE方案共享相同的趋势为延迟的结果,如图所示图10 b最大,BGV使用能源而德国情报机构消耗最小的能量。

第二,所有FHE神经网络推理上执行我们的硬件加速器BTS基线。作为图10 c节目,为小规模的网络日志,BGV达到最短的推理延迟,虽然CKKS是最慢的,即,2.3×推理延迟。中型和大型网络洛拉,汉堡,和亚历克斯,德国情报机构是最快的,而CKKS仍然是最慢的。自从BTS功耗运行这些FHE-based神经推断类似于对方,FHE-based神经网络的能量是由其决定延迟。因此,作为图10 d展览,各种FHE-based神经推论的能源消耗同样的趋势,因为延迟的结果。

第三,尽管CKKS通常是最慢在FHE-based神经推论,CKKS-based神经网络实现推理精度最高,如图所示图10 e。这是因为CKKS支持定点表示法。此外,每次FHE乘法,至少丢弃CKKS执行尺度改变操作有效数字,只关注最有效数字,提高推理精度。

5.2 CoFHE NAND-SPIN和SRAM混合暂时存储器

延迟和能量。NAND-SPIN和SRAM的推理延迟和能量混合暂时存储器系统所示图11。所有结果归一化和512 MB的SRAM BTS暂时存储器系统。我们假定我们的混合暂时存储器有相同的面积开销512 MB内存存储器便条簿。对于同一地区,CoFHE混合暂时存储器系统可以达到800 MB的容量。作为图11亮点,大容量混合暂时存储器减少中期和大规模的延迟FHE-based神经网络12.7%∼20%。小规模网络不获得受益于更大的便条簿,自500 MB SRAM便条簿足够容纳它的工作集。混合便条簿800 MB内存仍然消耗的功率要小得多比512 MB内存存储器便条簿。作为图11 b所示,800 MB混合暂时存储器系统的能源消耗降低BTS 32%∼44%为不同FHE-based神经网络。

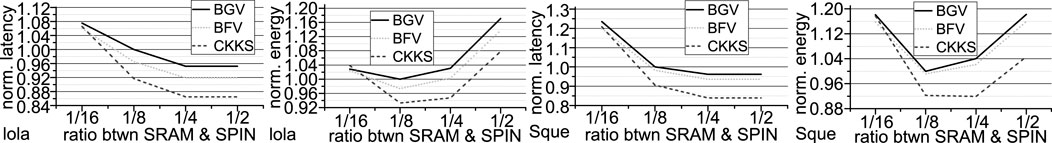

设计空间探索。我们调整SRAM和NAND-SPIN数组之间的能力比我们1/16∼1/2的混合暂时存储器系统。延迟和能量洛拉和短时的结果图12。1/8的比例相比,虽然少了SRAM阵列(比率= 1/16)稍微减少混合暂时存储器系统的力量,实现两个网络的延迟三个FHE方案大大延长了8%∼33%。因此,1/8的比率相比,1/16的比率会增加的能源开销。另一方面,更多的SRAM阵列(比率= 1/4)只有适度减少两个网络的延迟,但大大增加混合便签电力消耗的内存

5.3把两个放在一起

我们同时使用CoFHE编译器和混合暂时存储器,和现在的延迟和能量的结果图13。实现最短的客户端设置延迟(clat),我们CoFHE编译器总是使用德国情报机构。CKKSBTS相比,CoFHE提高了推理延迟和28%的推理能源34%。获取短服务器推理延迟(百叶),我们CoFHE编译器采用BGV日志,和德国情报机构其他神经网络。CoFHE减少了推理延迟和37%的推理能源41% CKKSBTS。有最高的准确性(acc),我们的CoFHE编译器总是选择CKKS网络。CoFHE降低了推理的混合暂时存储器延迟平均18%和推理能源26%。

6结论

在本文中,我们提出一个软件和硬件协同设计FHE-based MLaaS框架,CoFHE。平均而言,在相同的安全性和准确性的限制,CoFHE加速各种FHE-based推断18%,并减少各种FHE-based推论的能源消耗26%。

数据可用性声明

在这项研究中提出的数据集可以在网上找到存储库。库的名称/存储库和加入数量(s)中可以找到这篇文章/补充材料。

作者的贡献

MZ做了所有实验。LJu回答一些问题。LJi贡献了这个想法。

的利益冲突

作者声明,这项研究是在没有进行任何商业或财务关系可能被视为一个潜在的利益冲突。

出版商的注意

本文表达的所有索赔仅代表作者,不一定代表的附属组织,或出版商、编辑和审稿人。任何产品,可以评估在这篇文章中,或声称,可能是由其制造商,不保证或认可的出版商。

引用

数据集巴达维,A。贝茨,J。,Bergamaschi, F., Cousins, D. B., Erabelli, S., Genise, N., et al. (2022).Openfhe:开源完全同态加密库。密码学ePrint存档,纸2022/915。可以在:https://eprint.iacr.org/2022/915。

Banerjee U。,Ukyab, T. S., and Chandrakasan, A. P. (2019). Sapphire: A configurable crypto-processor for post-quantum lattice-based protocols.IACR反式。Cryptogr。测控。嵌入。系统。2019年,17 - 61。doi: 10.46586 / tches.v2019.i4.17 - 61

Boemer F。,Costache, A., Cammarota, R., and Wierzynski, C. (2019). “Ngraph-he2: A high-throughput framework for neural network inference on encrypted data,” inACM加密计算研讨会&应用同态加密,45-56。

交易所,F。,Minelli, M., Minihold, M., and Paillier, P. (2018). “Fast homomorphic evaluation of deep discretized neural networks,” in密码学的发展,483 - 512。

Brakerski, Z。绅士,C。,和V一个我kuntanathan, V. (2014). (leveled) fully homomorphic encryption without bootstrapping.ACM反式。第一版。理论6,1-36。doi: 10.1145 / 2633600

Brutzkus,。,Gilad-Bachrach, R。,和Elisha, O. (2019). “Low latency privacy preserving inference,” in国际会议上机器学习,812 - 821。

Chillotti,我。伽马,N。,Georgieva, M., and Izabachène, M. (2018). Tfhe: Fast fully homomorphic encryption over the torus.j . Cryptol。33、34 - 91。doi: 10.1007 / s00145 - 019 - 09319 - x

Dathathri, R。,Kostova B。,Saarikivi, O., Dai, W., Laine, K., and Musuvathi, M. (2020). “Eva: An encrypted vector arithmetic language and compiler for efficient homomorphic computation,” inACM SIGPLAN会议上编程语言设计和实现,546 - 561。

Dathathri, R。,Saarikivi, O., Chen, H., Laine, K., Lauter, K., Maleki, S., et al. (2019). “Chet: An optimizing compiler for fully-homomorphic neural-network inferencing,” inACM SIGPLAN会议上编程语言设计和实现,142 - 156。

咚,X。徐,C。,X我e,Y., and Jouppi, N. P. (2012). Nvsim: A circuit-level performance, energy, and area model for emerging nonvolatile memory.IEEE反式。计算机辅助Des。中国。电路系统。31日,994 - 1007。doi: 10.1109 / tcad.2012.2185930

Ducas, L。,和Micciancio, D. (2015). “Fhew: Bootstrapping homomorphic encryption in less than a second,” in密码学的发展——EUROCRYPT 2015。EUROCRYPT 2015。课堂讲稿在计算机科学()。编辑e·奥斯瓦尔德和m . Fischlin(柏林,海德堡:施普林格),9056卷,617 - 640。doi: 10.1007 / 978 - 3 - 662 - 46800 - 5 -大于

Gilad-Bachrach, R。Dowlin, N。莱恩,K。,l一个uter,K。Naehrig, M。,和Wernsing, J. (2016). “Cryptonets: Applying neural networks to encrypted data with high throughput and accuracy,” in国际会议上机器学习,201 - 210。

Hoofnagle c J。,v一个nder Sloot, B., and Borgesius, F. Z. (2019). The European Union general data protection regulation: What it is and what it means.正,Commun。抛光工艺。法律28日,65 - 98。doi: 10.1080 / 13600834.2019.1573501

金米。,Song, Y., Wang, S., Xia, Y., and Jiang, X. (2018). Secure logistic regression based on homomorphic encryption: Design and evaluation.JMIR地中海,正无穷。6,e19。doi: 10.2196 / medinform.8805

金,S。,K我米,J., Kim, M. J., Jung, W., Kim, J., Rhu, M., et al. (2022). “Bts: An accelerator for bootstrappable fully homomorphic encryption,” inIEEE / ACM国际研讨会上计算机体系结构,711 - 725。

卢,Q。,Feng, B., Fox, G. C., and Jiang, L. (2020). “Glyph: Fast and accurately training deep neural networks on encrypted data,” in年会在神经信息处理系统,9193 - 9202。

卢,Q。,和Jiang, L. (2021). “Hemet: A homomorphic-encryption-friendly privacy-preserving mobile neural network architecture,” in国际会议上机器学习。139卷。,7102 - 7110。

卢,Q。,和Jiang, L. (2019). “She: A fast and accurate deep neural network for encrypted data,” in先进的神经信息处理系统(美国纽约红钩:Curran Associates Inc .)),32卷,10035 - 10043。

麦克拉伦,c, E。、陈W.-P。聂,K。,和Su, M.-Y. (2009). Prediction of malignant breast lesions from mri features: A comparison of artificial neural network and logistic regression techniques.专科学校Radiol。16,842 - 851。doi: 10.1016 / j.acra.2009.01.029

Riazi, m . S。莱恩,K。,Pelton, B., and Dai, W. (2020). “Heax: An architecture for computing on encrypted data,” inACM国际会议架构支持的编程语言和操作系统,1295 - 1309。

里贝罗,M。,Grolinger, K., and Capretz, M. A. M. (2015). “MLaaS: Machine learning as a Service,” inIEEE国际会议上机器学习和应用程序(美国佛罗里达州迈阿密的:IEEE),896 - 902。doi: 10.1109 / ICMLA.2015.152

岗,N。,Feldmann, A., Krastev, A., Devadas, S., Dreslinski, R., Peikert, C., et al. (2021). “F1: A fast and programmable accelerator for fully homomorphic encryption,” inIEEE / ACM国际研讨会微体系结构,2021年10月17日,238 - 252。doi: 10.1145/3466752.3480070

岗,N。,Feldmann, A., Krastev, A., Manohar, N., Genise, N., Devadas, S., et al. (2022). “Craterlake: A hardware accelerator for efficient unbounded computation on encrypted data,” inIEEE / ACM国际研讨会上计算机体系结构,2022年6月11日,173 - 187。doi: 10.1145/3470496.3527393

关键词:完全同态加密,MLaaS,硬件加速器,编译器,软件和硬件共同设计

引用:郑M, L和江L (2023) CoFHE:软件和硬件共同设计FHE-based机器学习作为服务。前面。电子。3:1091369。doi: 10.3389 / felec.2022.1091369

收到:2022年11月07;接受:2022年12月26日;

发表:2023年1月12日。

编辑:

Avi Mendelson以色列理工学院理工学院,以色列版权©2023郑,榉和江。这是一个开放分布式根据文章知识共享归属许可(CC)。使用、分发或复制在其他论坛是允许的,提供了原始作者(年代)和著作权人(s)认为,最初发表在这个期刊引用,按照公认的学术实践。没有使用、分发或复制是不符合这些条件的允许。

*通信:Lei江,jiang60@iu.edu

Mengxin郑

Mengxin郑 Lei居2和

Lei居2和 Lei江

Lei江